डीप फेक आपका फोटो विडियो को बदलकर देता है मनचाहा रूप

इस तकनीक के नफा-नुकसान पर एक पड़ताल

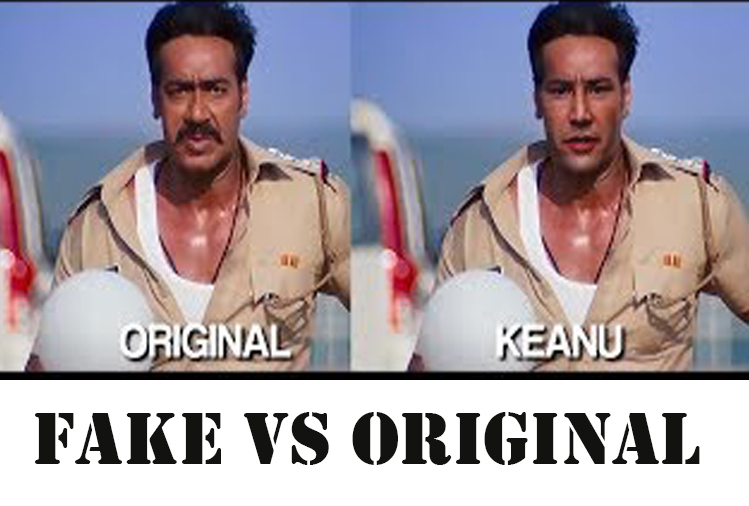

मार्केट में आया एक एप्लीकेशन है जिसके जरिए आपके निजी फोटो या वीडीओ को एडिट कर उन्हे मनचाहे तरीके प्रस्तुत किया जा सकता है ।यानि इस तकनीक से किसी के भी विडियो या फोटो पर मनचाहे लोगों के विडियो फोटो डालकर आवाज, चेहरा और भावभंगिमाओं को बदला जा सकता है।

कैसे और किस तरह ?

इसे समझने के लिए सबसे पहले समझना होगा इस तकनीक का नाम क्या है?

इस तकनीक को डीपफेक (Deepfake) कहते हैं । पहले इसका इस्तेमाल फिल्मों में डबल रोल या चेहरे को दूसरा रूप देने के लिए इस्तेमाल किया जाता था। यह तकनीक डीप लर्निंग और फेक का मिश्रण हैं। इस तकनीक में किसी का भी फोटा या वीडियो लेकर उसके चेहरे की भाव भंगीमा को बदला जा सकता है ।  किसी की भाषा बोली में उसके डायलॉग लगाए जा सकते हैं । इस तकनीक की मदद से आप अगर चाहें तो अमिताभ के डायलॉग बोल सकते हैं यानि आवाज अमिताभ की होगी और चेहरा आपका होगा या आवाज आपकी होगी और डायलॉग अमिताभा बोलेगें। है न मजेदार ! ।ये पूरा काम Artificial Intelligence यानि क्रित्रिम बुद्धिमत्ता तकनीक करती है।

किसी की भाषा बोली में उसके डायलॉग लगाए जा सकते हैं । इस तकनीक की मदद से आप अगर चाहें तो अमिताभ के डायलॉग बोल सकते हैं यानि आवाज अमिताभ की होगी और चेहरा आपका होगा या आवाज आपकी होगी और डायलॉग अमिताभा बोलेगें। है न मजेदार ! ।ये पूरा काम Artificial Intelligence यानि क्रित्रिम बुद्धिमत्ता तकनीक करती है।

क्रत्रिम बुद्धिमत्ता

क्रत्रिम बुद्धिमत्ता वह तकनीक है जिसके जरिए सोचने समझने वाली मशीनों का निर्माण किया जाता है । इसकी शुरूआत 1950 में हो चुकी थी मगर लोगों ने इसे 1970 के बाद ही गंभीरता से लिया ।

रजनीकांत की रोबोट के अलावा , स्टारवार्स, टर्मिनेटर, आई रोबोट जैसी कुछ फिल्में बनी है जो क्रत्रिम बुद्धिमत्ता पर आधारित है जिसमें रोबोट इंसान की तरह सोच समझ सकते हैं। ये सच है कि 1997 में शतरंज के महान खिलाड़ी गैरी कोस्पोरोव को आर्टिफिशअल इंटेलीजेंस वाला कम्प्यूटर हरा चुका है।

आर्टिफिशअल इंटेलिजेंस के बारे में आप समझ ही गए होंगें । बात हो रही है डीप फेक तकनीक की । यह तकनीक भी इसी आर्टिफिषअल यानि क्रत्रिम बुद्धिमत्ता की सहायता से काम करता है।

मगर इसके कुछ नुकसान भी हैं ।

डीप फेक के नकारात्मक प्रभाव भी है। इसका पहला मामला 1917 में आया जब रेडिट नाम के सोशल मिडिया में डीपफेक नाम के अकाउण्ट पर नामचीन हस्तियों के तस्वीरें सामने आयीं और फिर उसके बाद से सोशल मिडिया में इस तरह के पोस्ट की एक बाढ़ सी आ गई ।

होने वाले नुकसान की बात करें तो सबसे बड़ा नुकसान तो यह है कि ऐसे विडियो या फोटो बनाकर किसी को बदनाम किया जा सकता है। उसका राजनीतिक,आर्थिक और सामाजिक जीवन मुश्किल में डाला सकता है। सोशल मिडिया में ऐसे विडियो आजकल आम हो चले हैं ।

उदाहरण के लिए बराक ओबामा, ट्रम्प,से लेकर टॉम क्रूज का वायरल वीडियो भी डीपफेक के इस्तेमाल से बनाए जा चुके हैं । पिछले साल प्रधानमंत्री मोदी, चीनी प्रधानमंत्री जी जिनपिंग और गृहमंत्री राजनाथ सिंह के साथ एक लाईन में खड़े होकर बॉलीवुड के किसी गाने पर होंठ हिलाते इस प्रकार दिखाया गया था कि मानो वे खुद इसे गा रहें है।

लोकतंत्र के लिए खतरा

राजनेताओं अधिकारियों और जनता से जुड़े लोगों को इस तकनीक के जरिए गलत तरीके से पेश कर बदनाम किया जा सकता है ।आज के टेक्नोलजी के समय में इसे बेहद खतरनाक भी माना जा रहा है। इसका गलत इस्तेमाल इसे फेक न्यूज से हजारों गुना ज्यादा खतरनाक बना देता है । पोर्न वीडियो में भी इसका काफी इस्तेमाल किया जाता है। डीपफेक के मामले लगातार बढ़ते जा रहें है। एषिया महाद्वीप में आंकड़ों के मुताबिक 2018 में जहां 7964 मामले थे 2020 आते आते ये मामले 49081 तक हो गए । इसी से इस बात का अंदाजा लगाया जा सकता है कि स्थिति कितनी गंभीर है।

मेसेजिंग एप पर ज्यादा हो रहा है इस्तेमाल

कुछ लोकप्रिय सोशल मैसेजिंग ऐप जैसे व्हाट्सएप्प, टेलीग्राम इंस्टाग्राम इत्यादि को लेकर एक बेहद परेशान करने वाली खबर सामने आई है । लगभग सभी मैसेजिंग ऐप ने पिछले दिनों में बहुत अधिक लोकप्रियता पाई है, क्योंकि इस पर किये जा रहे मैसेज और अन्य मीडिया की न सिर्फ प्राइवेसी का पक्का इंतजाम होता है बल्कि इसपर बड़ी फाइलें भी आसानी से शेयर की जा सकती हैं लेकिन अब ये ऐप भी एक कंट्रोवर्सी में फंस गए है। कही आपके फोटो या विडियो भी तो नही आ गए ? इसमे अगर इस तरह की किसी भी तकनीक से सामना आपका होता है तो जरूर इसका विरोध कीजिए।

अमेरिकन कम्प्यूटर साइंस के फाउण्डर और पिन स्क्रीन के सीईओ हाओ ली जो फयूरिअस-7 और हाबिट जैसी फिल्मों में विजुअल इफेक्ट के लिए फेस ट्रेकिंग और डिजीटाईजेषन पर काम कर चुके है। वे बताते है। कि अगर कोई शख्स दूसरे के चेहरे पर अपना चेहरा लगाना चाहता है तो दोनों के चेहरों की फोटा काफी मात्रा में चाहिए । इन सबको एकत्र करके डीप न्यूरल नेटवर्क से ट्रेन करना होता है ।

फिर आगे चलकर तकनीकी ज्ञान बढ़ा तो कई तरह के एप भी मार्केट में आए।प्लेस्टोर में ऐसे एप्लीकेषन की भरमार है।

ध्यान रखना होगा।

हालांकि विशेषज्ञ कहते हैं कि यह तो आपके इस्तेमाल का नजरिया तय करेगा कि तकनीक फायदेमंद होगी या खतरनाक । आग सबसे पुरानी तकनीक है। यह खाना भी पकाती है और लोगों को मारती भी है। असल समस्या तो गलत सूचनाएँ हैं । कंप्यूटर या प्रिंट तो सिर्फ माध्यम हैं।

इसके जरिए अब तक हजारों महिलाओं और लड़कियों की एक लाख न्यूड तस्वीरें आनलाईन साझा की जा चुकी हैं । ये तस्वीरें जुलाई 2019 और 2020 के बीच एआई-बॉट का उपयोग करके बनाई गई थीं । पीड़ितों में से अधिकांश की ये निजी तस्वीरें थी, जिन्हें सोशल मीडिया से लिया गया था’.

रिपोर्ट में यह बात सामने आई है कि ये परेशान करने वाली फोटोज आर्टिफिशियल इंटेलिजेंस के एक साधारण प्रयोग पर आधारित हैं और इसी के जरिए बनाई गई हैं ये सभी बिल्कुल वास्तविक लग सकती हैं।

यानि अगर गलत हाथों में ये आ जाए तो झूठी खबरें फैलाना कोई बड़ी बात नहीं है । इस बात की सफाई के लिए कुछ संगठन वायरल वीडियो का सच नामक कार्यक्रम भी कर रहीं है। और इनसे निपटने के लिए सख्त कानून भी हैं ।

क्या है कानूनी प्रावधान ?

भारतीय साईबर अपराध समन्वय केन्द्र की स्थापना हुई है। साइबर अपराधों निपटने के लिए केंद्रीय इलेक्ट्रॉनिक्स एवं सूचना प्रौद्योगिकी मंत्रालय के तहत साइबर स्वच्छता केंद्र भी बनाया गया है ।

नागरिकों के व्यक्तिगत डेटा को सुरक्षा प्रदान करने के लिये दिसंबर 2019 में ‘व्यक्तिगत डेटा संरक्षण विधेयक, 2019’ लोकसभा में प्रस्तुत किया गया था जिसके बाद इसे स्थायी समिति के पास भेज दिया गया है।

देश में साइबर अपराधों के मामलों में वर्ष 2000 में पारित ‘सूचना प्रौद्योगिकी अधिनियम-2000’ तथा भारतीय दंड संहिता के प्रावधानों के तहत कार्रवाई की जा सकती है। प्रत्येक शहर में साईबर सेल की स्थापना की गई । और पुलिस विभाग समय समय पर साईबर मामलों को लेकर लोगों को सचेत कर रही है।

ये भी है प्रगति

स्टैनफोर्ड यूनिवर्सिटी और यूसी बर्कले के शोधकर्त्ताओं ने एक प्रोग्राम तैयार किया है जो कृत्रिम बुद्धिमत्ता का उपयोग कर डीप फेक वीडियो की पहचान करने में सक्षम है। इसे लेकर एक शोध निकाला गया है इसका शीर्षक है ‘डिटेक्टिंग डीप-फेक वीडियोज़ फ्रॉम फेनोम-विसेम मिसमैच’ शोध के अनुसार, यह प्रोग्राम किसी मीडिया फाइल में लोगों की आवाज़ और उनके मुँह के आकार में सूक्ष्म भिन्नताओं के माध्यम से 80 फसदी मामलों में डीप फेक वीडियो की पहचान करने में सफल रहा। आने वाले समय में इस दिशा में और प्रगति की संभावना है। मगर आप सावधान रहें !